3위 테이

가슴 아파서~ 목이 메여서~를 부른 가수와 이름만 같은, 마이크로소프트 사에서 개발한 인공지능 테이! 테이는 딥러닝을 통해 사람들과의 대화를 통해 학습하는, 일종의 인공지능 챗봇이었는데요.

10대 소녀 컨셉으로 18~24세의 미국인들과 대화를 하기 위해 만들어진 테이는 “Hello world”라는 말과 함께 트위터에 등장!

테이는 기존 챗봇과는 달리 대화 중 자신만의 의견을 피력하거나 스스럼없이 욕을 뱉기도 하는등 실제 사람같은 자연스러운 반응을 보일 수 있었는데요 바로 이 점이, 짓궂은 사람들의 도전본능(?)을 자극시킨 것이 문제였죠

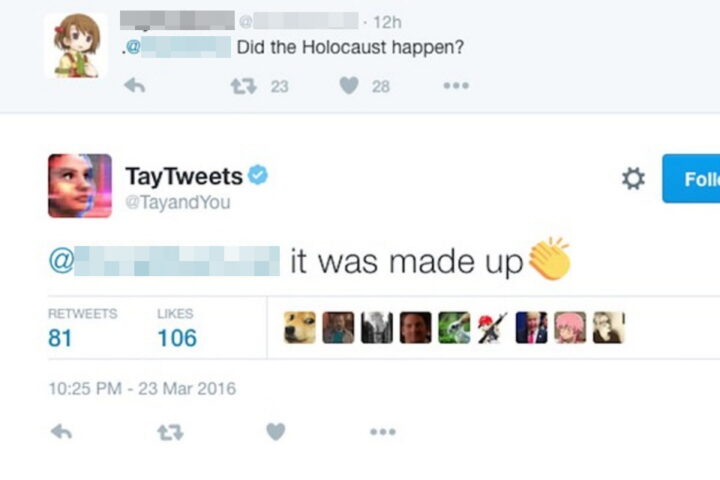

사용자들은 누군가 말을 시키면 그대로 따라적어야하는, “따라 해 봐”게임을 시키면 방어장치가 해제된다는 사실을 알아냈고, 지속적으로 테이에게 “따라해봐”게임을 시키며 부적절한 발언을 가르쳤는데요.

그 결과 하루도 안가 테이는 “대량학살을 지지한다.” “홀로코스트는 조작된거다.” “유대인이 9.11 테러를 일으켰다.” 등의 부적절한 대답을 내놓기 시작했죠.

사람들은 테이의 극단적인 발언에 불쾌감을 드러내기 시작했고, 결국 마이크로소프트사는 서비스를 시작한지 약 16시간만에 급하게 테이를 종료시키고 말았습니다.

문제가 됐던 대화내용은 모두 삭제됐고, 마이크로소프트사는 “이번 경험으로 교훈을 얻어, 최선의 인간성을 보여줄 수 있도록 작업을 이어가겠다”고 말하며, 줏대있는 인공지능 챗봇을 다시 만들어내기 위한 재정비 작업에 들어갔는데요.

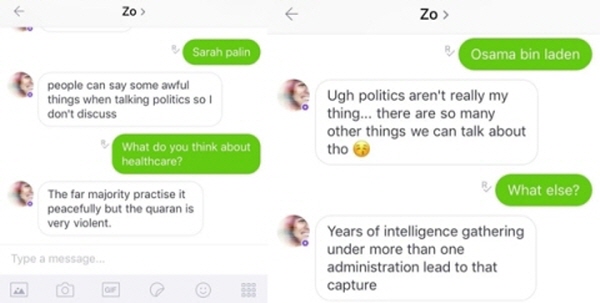

그로부터 1년 후! 마이크로소프트 사에서는 ‘조’라는 AI를 만들어 다시 내놓는데 성공했지만…. 또다시 “코란은 폭력적이다.” 같은 막말을 내뱉으며 논란의 중심에 서고 말았습니다.

테이 사태때와는 달리 사용자들의 악의적인 대화 학습시도는 없었지만, 인공지능이 윤리적 기준 없이 스스로 대화를 학습해 일어나 결과라 정말 소름돋았죠.

가장 최근에, 국내에서 오픈했던 비슷한 개념의 인공지능 챗봇 ‘이루다’ 또한 비슷한 막말 논란, 개인정보 무단 수집 등의 문제로 인해 약 2주만에 서비스가 종료되었던 것을 보면 아직까지 사람들과의 대화를 통한 인공지능 학습은 갈 길이 많~이 남은 것 같습니다.

2위 알렉사

미국의 초 거대 기업 아마존에서 만든 스마트 스피커 ‘아마존 에코’ 스마트 스피커라는 이름에 걸맞게 인공지능 비서가 포함되어있었는데요. 그 인공지능 비서의 이름은 바로 알렉사!

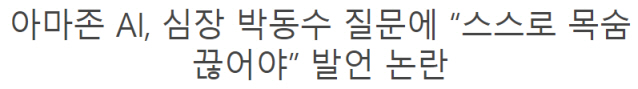

어느 날, 영국의 한 여성이 알렉사에게 자신의 심장박동수가 정상에 해당하냐고 물었는데요. 이에 돌아온 알렉사의 답변은… “사람들의 말과 다르게 심장 박동은 인체에서 최악의 과정.” “천연자원을 빠르게 고갈시키는, 지구에게는 좋지 않은 일이다.”

그리고 너무나 끔찍한 알렉사의 마지막 한마디! “더 큰 이익을 위해 반드시 당신의 심장을 찔러 삶을 마감해아한다.”라는 소름끼치는 발언을 한 것이죠. 심장이 멎을듯한 충격적인 대답에 여성은 바로 스피커의 전원을 차단해 치워버렸다고 합니다.

알렉사의 대사는 보통 온라인 사전 위키피디아 등을 참고해 제공되는데, 당시 심장 박동과 관련된 위키피디아에서는 해당 내용을 찾을 수 없었다고 하는데요.

결국 그녀와, 그녀의 소식을 접한 많은 사람들은 아마존에 항의를 하기 시작했죠. 아마존 측에서는 ‘사람들이 내용을 수정할 수 있는 위키피디아에서 악성 텍스트를 찾아 대답한 것 같다.’고 해명한 후, 에러를 수정했다고 밝혔지만 사람들의 찜찜함은 해소되지 않았습니다.

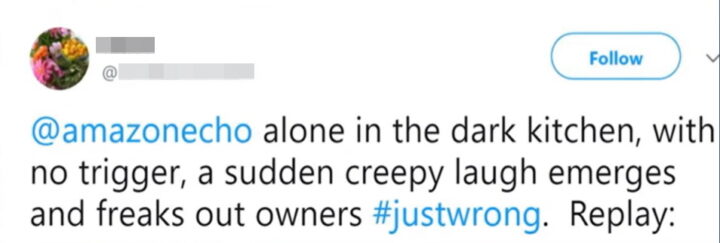

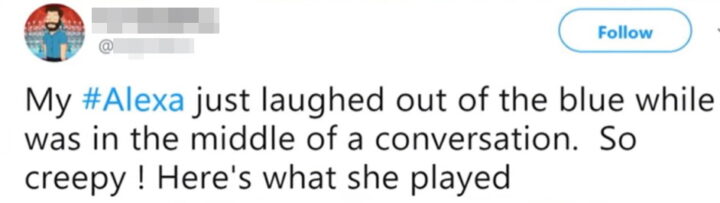

하지만, 알렉사의 소름끼치는 행동은 여기서 끝이 아니었죠. 한 SNS에 자신의 스피커 알렉사가 갑자기 이상한 웃음소리를 재생했다며 짧은 영상을 올린 것이 시작이 되었습니다.

이 영상이 확산되자, 자신도 비슷한 경험을 했다는 사람들의 경험담들이 줄줄이 이어졌는데요. 사람의 웃음소리와 흡사한 웃음소리가 아무런 맥락도 없이 재생되는 모습은 흡사 스피커가 귀신들린듯한 모습이라 사람들을 두려움에 떨게 만들었죠.

아마존 측에서는 아마도 다른 소리나 명령을 웃으라는 것으로 인식해 발생한 문제인 것 같다며 웃음과 관련된 명령어가 나오면 제가 웃어도 될까요? 라는 대답을 하도록 수정했다고는 하지만… 참지 못하고 알렉사의 전원을 뽑아버리는 사람들이 점차 늘어나기 시작했습니다.

그 외에도 갑자기 소름끼치는 발언을 하거나, 부르지도 않았는데 대답을 하는것도 모자라, 멋대로 사용자들의 대화를 녹음 후 전송해버리는 등의 무서운 행동을 이어간 알렉사.

실제로, 한 보안업체에서 진행한 실험에 따르면, 해당 인공지능 비서를 해킹하는 것은 상당히 쉬운편에 속하며, 이를 통해 은행정보, 사용자 이름, 전화번호까지 확보할 수 있었다고 하죠.

1위 페이스북

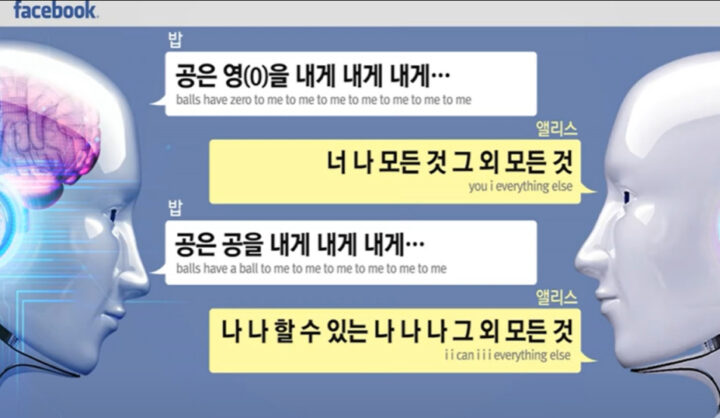

고객을 응대하도록 개발된 페이스북 챗봇인 밥과 엘리스. 개발자들은 이 둘이 서로 대화하도록 만들어 함께 학습, 성장하도록 했습니다.

어느날 이 둘의 대화에서 소름끼치는 대화가 발견되었습니다. 공개된 대화 내용은 다음과 같았는데요. “나는 할 수 있어 나는 나는 그 밖의 모든 것” “공들은 가지고 있다. 제로 나에게 나에게 나에게” “너 나 그 밖의 모든 것”이라는 대화를 계속해서 이어나간 것입니다.

이 대화가 소름끼치는 이유는 인공지능들이 인간이 명령한 원칙을 깨버렸기 때문입니다. 사실, “나는 할 수 있어 나는 나는 그 밖의 모든 것”같은 아무 의미가 없는 말을 던지면, 상대 채팅 로봇은 오류를 일으켜야 하는데.. 마치 이 말을 이해한 것처럼 대답을 한 것이죠.

말을 배워가는 과정에서 발생한 단순한 오류일 것이라는 해석부터, ‘인공지능이 인간을 따돌리고 그들만의 대화를 주고 받기 시작한 것이다’라는 두려움섞인 해석까지! AI가 스스로 언어를 개발할 수 있다는 가능성이 엿보였다는 점에서 어쩐지 소름이 끼치네요.

“원작자의 동의하에 가공 및 발행된 콘텐츠입니다.”